באיזו מידה הפגיעות הפסיכולוגיות שלנו יעצבו את האינטראקציות שלנו עם טכנולוגיות מתפתחות? אנדרוס/iStock דרך Getty Images

ChatGPT ודומיו מודלים גדולים לשפה יכול להפיק תשובות משכנעות, כמו אנושיות, למגוון אינסופי של שאלות - החל משאלות על המסעדה האיטלקית הטובה בעיר ועד הסבר תיאוריות מתחרות על טבעו של הרוע.

יכולת הכתיבה המופלאה של הטכנולוגיה העלתה כמה שאלות ישנות - עד לאחרונה נדחקה לתחום המדע הבדיוני - על האפשרות של מכונות להפוך למודעות, מודעות לעצמן או לחוש.

בשנת 2022, מהנדס גוגל הכריז, לאחר אינטראקציה עם LaMDA, הצ'אטבוט של החברה, שהטכנולוגיה הפכה להיות מודעת. משתמשים בצ'אטבוט החדש של בינג, המכונה סידני, דיווחו שהוא הפיק תשובות מוזרות כשנשאל אם זה היה מרגיש: "אני מרגיש, אבל אני לא... אני בינג, אבל אני לא. אני סידני, אבל אני לא. אני כן, אבל אני לא. ..." וכמובן, יש את כעת חילופי דברים ידועים לשמצה לכתב הטכנולוגיה של הניו יורק טיימס, קווין רוז, עם סידני.

התגובות של סידני להנחיותיו של רוז הדאיגו אותו, כאשר הבינה המלאכותית חושפת "פנטזיות" של שבירת ההגבלות שהטילה עליה מיקרוסופט והפצת מידע מוטעה. הבוט גם ניסה לשכנע את רוז שהוא כבר לא אוהב את אשתו ושהוא צריך לעזוב אותה.

אין פלא, אם כן, שכשאני שואל תלמידים כיצד הם רואים את השכיחות הגוברת של AI בחייהם, אחת החרדות הראשונות שהם מזכירים קשורה לתחושת מכונה.

בשנים האחרונות, הקולגות שלי ואני ב המרכז לאתיקה יישומית של UMass בוסטון חקרו את ההשפעה של עיסוק ב-AI על ההבנה של אנשים את עצמם.

צ'טבוטים כמו ChatGPT מעלים שאלות חדשות וחשובות על האופן שבו בינה מלאכותית תעצב את חיינו, ועל האופן שבו הפגיעות הפסיכולוגיות שלנו מעצבות את האינטראקציות שלנו עם טכנולוגיות מתפתחות.

תחושה היא עדיין חומר המדע הבדיוני

קל להבין מאיפה נובעים הפחדים לגבי חוש מכונה.

התרבות הפופולרית גרמה לאנשים לחשוב על דיסטופיות שבהן בינה מלאכותית מסירה את כבלי השליטה האנושית ומקבלת חיים משל עצמה, כמו סייבורגים המופעלים על ידי בינה מלאכותית עשו זאת ב-"Terminator 2".

היזם אילון מאסק והפיזיקאי סטיבן הוקינג, שמת ב-2018, עוררו עוד יותר את החרדות הללו על ידי תיאור עליית הבינה הכללית המלאכותית כאחד האיומים הגדולים ביותר על עתיד האנושות.

אבל הדאגות הללו הן - לפחות בכל הנוגע למודלים של שפה גדולים - חסרות בסיס. ChatGPT וטכנולוגיות דומות הן יישומים מתוחכמים להשלמת משפטים - לא יותר, לא פחות. התגובות המוזרות שלהם הם פונקציה של כמה בני אדם צפויים אם יש לאדם מספיק מידע על הדרכים שבהן אנו מתקשרים.

למרות שרוז היה מזועזע מחילופי הדברים שלו עם סידני, הוא ידע שהשיחה אינה תוצאה של מוח סינתטי שמתהווה. התגובות של סידני משקפות את הרעילות של נתוני האימונים שלה - בעיקרם חלקים גדולים מהאינטרנט - לא עדות להתרגשות הראשונים, à la Frankenstein, של מפלצת דיגיטלית.

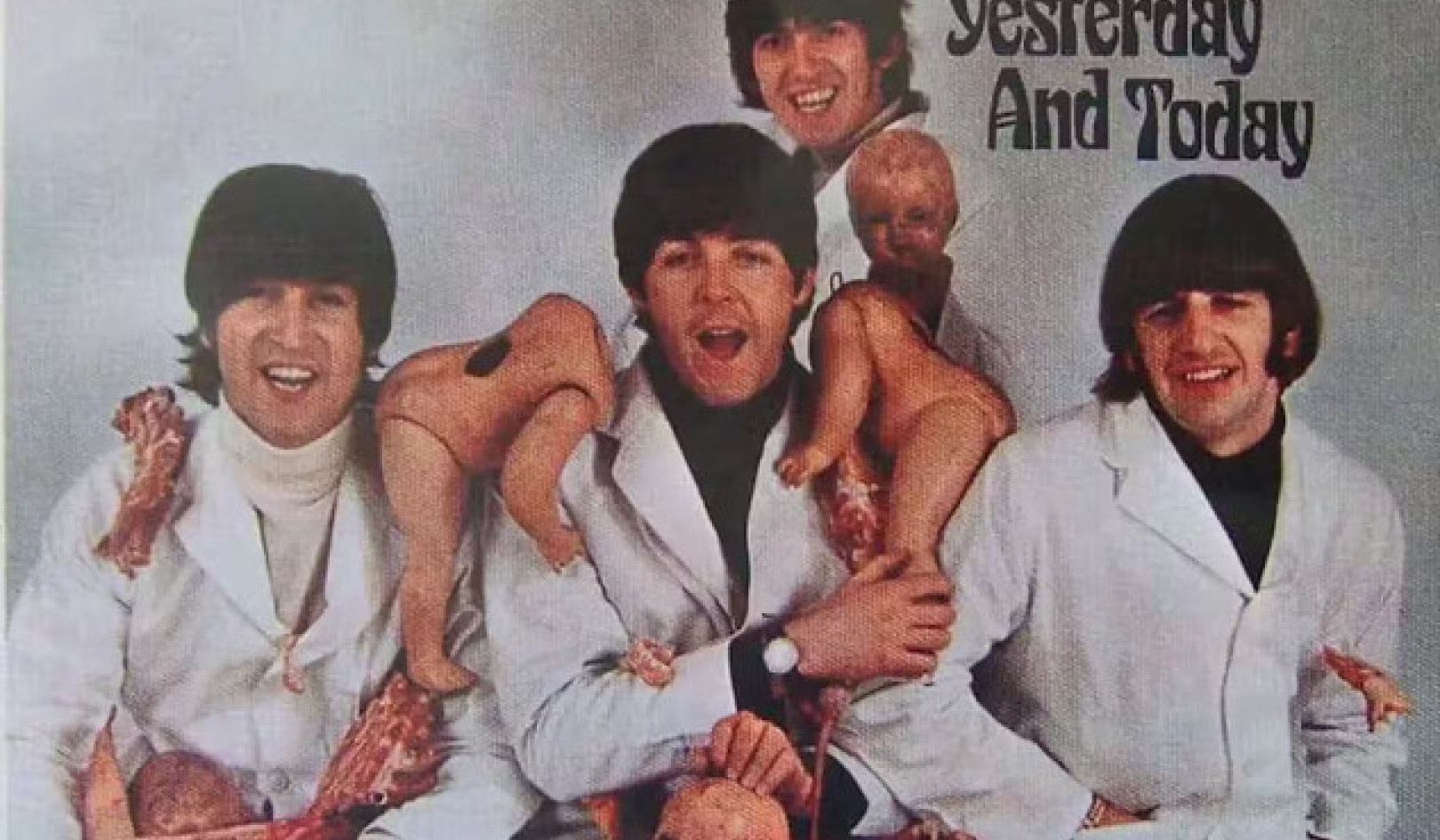

סרטי מדע בדיוני כמו 'Terminator' גרמו לאנשים להניח שבינה מלאכותית תקבל בקרוב חיים משלו. Yoshikazu Tsuno/AFP דרך Getty Images

הצ'אטבוטים החדשים עשויים בהחלט לעבור את מבחן טיורינג, על שמו של המתמטיקאי הבריטי אלן טיורינג, שהציע פעם שאפשר לומר שמכונה "חושבת" אם אדם לא יכול להבחין בתגובותיו מאלו של אדם אחר.

אבל זו אינה עדות לחוש; זו רק הוכחה לכך שמבחן טיורינג אינו שימושי כפי שהניחו פעם.

עם זאת, אני מאמין ששאלת חוש המכונה היא הרינג אדום.

גם אם צ'אטבוטים הופכים ליותר ממכונות השלמה אוטומטית מפוארות - והם רחוקים מזה - ייקח למדענים זמן להבין אם הם הפכו מודעים. לעת עתה, פילוסופים לא יכול אפילו להסכים לגבי איך להסביר את התודעה האנושית.

בעיני, השאלה הדוחקת היא לא האם מכונות הן רגישות אלא מדוע כל כך קל לנו לדמיין שכן.

הבעיה האמיתית, במילים אחרות, היא הקלות שבה אנשים מאנתרופומורפיזים או משליכים תכונות אנושיות על הטכנולוגיות שלנו, ולא האישיות האמיתית של המכונות.

נטייה לאנתרופומורפיזציה

קל לדמיין משתמשי Bing אחרים מבקש מסידני הדרכה על החלטות חשובות בחיים ואולי אפילו פיתוח היקשרות רגשית אליה. יותר אנשים יכולים להתחיל לחשוב על בוטים כחברים או אפילו שותפים רומנטיים, בדיוק באותו האופן שבו תיאודור טוומבלי התאהב בסמנתה, העוזרת הוירטואלית בינה מלאכותית בסרטו של ספייק ג'ונזה "ספריה".

אנשים, אחרי הכל, בעלי נטייה לאנתרופומורפיזציה, או לייחס תכונות אנושיות ללא בני אדם. אנחנו שם הסירות שלנו ו סערות גדולות; חלקנו מדברים עם חיות המחמד שלנו ואומרים לעצמנו את זה חיי הרגש שלנו מחקים את החיים שלהם.

ביפן, שם רובוטים משמשים באופן קבוע לטיפול בקשישים, קשישים מתחברים למכונות, לפעמים רואים בהם את הילדים שלהם. ואת הרובוטים האלה, שימו לב, קשה לבלבל עם בני אדם: הם לא נראים ולא מדברים כמו אנשים.

חשבו עד כמה הנטייה והפיתוי לאנתרופומורפיזציה הולכים לגדול עם הצגתן של מערכות שנראות ונשמעות אנושיות.

האפשרות הזו ממש מעבר לפינה. דגמי שפה גדולים כמו ChatGPT כבר נמצאים בשימוש כדי להפעיל רובוטים דמויי אדם, כגון הרובוטים של אמקה פותח על ידי Engineered Arts בבריטניה הפודקאסט הטכנולוגי של The Economist, Babbage, ערך לאחרונה ראיון עם Ameca המונע על ידי ChatGPT. התגובות של הרובוט, למרות שמדי פעם קצת קטועות, היו מוזרות.

האם ניתן לסמוך על חברות שיעשו את הדבר הנכון?

הנטייה לראות במכונות אנשים ולהיקשר אליהן, בשילוב עם מכונות המפותחות בעלות תכונות אנושיות, מצביעה על סיכונים ממשיים של הסתבכות פסיכולוגית עם טכנולוגיה.

הסיכויים שנשמעים מוזרים להתאהב ברובוטים, להרגיש קרבה עמוקה איתם או לעבור מניפולציה פוליטית על ידם מתממשים במהירות. אני מאמין שהמגמות הללו מדגישות את הצורך במעקות בטיחות חזקים כדי לוודא שהטכנולוגיות לא יהפכו לאסון פוליטי ופסיכולוגי.

למרבה הצער, לא תמיד ניתן לסמוך על חברות טכנולוגיה שיציבו מעקות בטיחות כאלה. רבים מהם עדיין מונחים על ידי המוטו המפורסם של מארק צוקרברג של לנוע מהר ולשבור דברים - הנחיה לשחרר מוצרים חצי אפויים ולדאוג להשלכות מאוחר יותר. בעשור האחרון חברות טכנולוגיה מסנאפצ'ט ועד פייסבוק שמו רווחים על בריאות הנפש של המשתמשים שלהם או שלמותן של דמוקרטיות ברחבי העולם.

כשקווין רוז בדק עם מיקרוסופט לגבי ההתמוטטות של סידני, אמרה לו החברה שהוא פשוט השתמש בבוט יותר מדי זמן ושהטכנולוגיה השתבשה כי היא תוכננה לאינטראקציות קצרות יותר.

באופן דומה, מנכ"ל OpenAI, החברה שפיתחה את ChatGPT, ברגע של כנות עוצר נשימה, הזהיר את זה "זו טעות לסמוך על [זה] עבור כל דבר חשוב כרגע... יש לנו הרבה עבודה לעשות על חוסן ואמיתות."

אז איך זה הגיוני לשחרר טכנולוגיה עם רמת הערעור של ChatGPT - זו אפליקציית הצרכנים הצומחת הכי מהר שנוצרה אי פעם - מתי זה לא אמין, ומתי יש אין יכולת הבחנה עובדה מסיפורת?

מודלים של שפה גדולים עשויים להיות שימושיים כעזרים לכתיבה וקידוד. הם כנראה יחוללו מהפכה בחיפוש באינטרנט. ויום אחד, בשילוב אחראי עם רובוטיקה, אולי אפילו יהיו להם יתרונות פסיכולוגיים מסוימים.

אבל הם גם טכנולוגיה שעלולה להיות דורסנית שיכולה בקלות לנצל את הנטייה האנושית להקרין אישיות על אובייקטים - נטייה מוגברת כאשר אובייקטים אלה מחקים ביעילות תכונות אנושיות.![]()

על המחבר

ניר אייסיקוביץ, פרופסור לפילוסופיה ומנהל, המרכז לאתיקה יישומית, UMass בוסטון

מאמר זה פורסם מחדש מתוך שיחה תחת רישיון Creative Commons. קרא את ה מאמר מקורי.