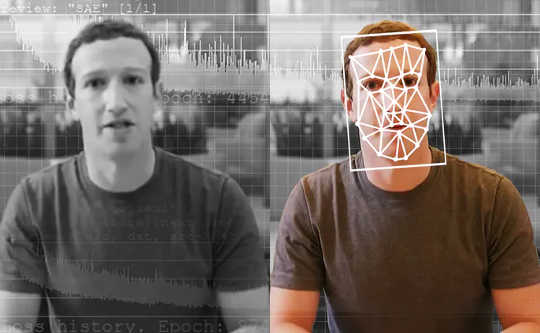

גלאים המופעלים על ידי AI הם הכלים הטובים ביותר לאיתור קטעי וידאו מזויפים שנוצרו על ידי AI. הוושינגטון פוסט דרך Getty Images

עיתונאי חוקר מקבל סרטון מאת מלשין אנונימי. זה מראה מועמד לנשיא מודה בפעילות בלתי חוקית. אבל האם הסרטון הזה אמיתי? אם כן, יהיו אלה חדשות ענקיות - סקופ של חיים שלמים - ויכולו להפוך לחלוטין את הבחירות הקרובות. אבל העיתונאית מריצה את הסרטון באמצעות כלי מיוחד, שאומר לה שהסרטון אינו מה שהוא נראה. למעשה, זה "עמוק, "סרטון שנעשה באמצעות בינה מלאכותית עם למידה עמוקה.

עיתונאים בכל רחבי העולם עשויים להשתמש בקרוב בכלי כזה. בתוך כמה שנים כלי כזה יכול אפילו לשמש את כולם להשריד תוכן מזויף בעדכוני המדיה החברתית שלהם.

As חוקרים שלמדו גילוי זיוף עמוק ופיתוח כלי לעיתונאים, אנו רואים עתיד לכלים אלה. הם לא יפתרו את כל הבעיות שלנו, והם יהוו רק חלק אחד מהארסנל במאבק הרחב יותר נגד דיסאינפורמציה.

הבעיה עם זיוף עמוק

רוב האנשים יודעים שאי אפשר להאמין לכל מה שרואים. במהלך העשורים האחרונים, צרכני חדשות נבונים התרגלו לראות תמונות מתופעלות באמצעות תוכנת עריכת תמונות. עם זאת, סרטונים הם סיפור אחר. במאים בהוליווד יכולים להוציא מיליוני דולרים על אפקטים מיוחדים כדי להוות סצנה מציאותית. אבל שימוש בזיופים עמוקים, חובבנים עם כמה אלפי דולרים של ציוד מחשב וכמה שבועות לבזבז עלולים לגרום למשהו להיות נכון כמעט לחיים.

זיוף עמוק מאפשר להכניס אנשים לסצינות קולנוע שמעולם לא היו בהן - חושב שטום קרוז משחק את איש הברזל - מה שעושה סרטונים משעשעים. למרבה הצער, זה גם מאפשר ליצור פורנוגרפיה ללא הסכמה של האנשים המתוארים. עד כה, אותם אנשים, כמעט כל הנשים, הם הקורבנות הגדולים ביותר כאשר נעשה שימוש לרעה בטכנולוגיה מזויפת.

בעזרת Deepfakes ניתן ליצור גם סרטונים של מנהיגים פוליטיים שאומרים דברים שמעולם לא אמרו. המפלגה הסוציאליסטית הבלגית פרסמה סרטון שאינו מזויף אך עדיין מזויף הנשיא טראמפ מעליב את בלגיה, שזכתה לתגובה מספקת כדי להראות את הסיכונים האפשריים של זיוף עמוק איכותי יותר.

{vembed Y = poSd2CyDpyA}

אוניברסיטת קליפורניה, האני פאריד בברקלי, מסבירה כיצד מייצרים זיופים עמוקים.

אוּלַי הכי מפחיד מכולם, ניתן להשתמש בהם ליצירה ספק לגבי תוכן הסרטונים האמיתיים, על ידי הצעה שהם יכולים להיות זיופים עמוקים.

בהתחשב בסיכונים אלה, יהיה זה בעל ערך רב להיות מסוגל לזהות זיופים עמוקים ולתייג אותם בצורה ברורה. זה יבטיח שסרטונים מזויפים לא יטעות את הציבור, ושהסרטונים האמיתיים יוכלו להתקבל כאותנטיים.

זיהוי זיופים

גילוי זיוף עמוק כשדה מחקר החל קצת יותר לפני שלוש שנים. עבודה מוקדמת התמקדה באיתור בעיות גלויות בסרטונים, כגון זיופים עמוקים שלא מצמצו. אולם עם הזמן, זיופים השתפרו לחקות סרטונים אמיתיים ולהיות קשה יותר לאתר גם עבור אנשים וגם עבור כלי איתור.

ישנן שתי קטגוריות עיקריות של מחקר זיהוי עמוק. הראשון כרוך מסתכל על התנהגות של אנשים בסרטונים. נניח שיש לך הרבה סרטונים של מישהו מפורסם, כמו הנשיא אובמה. בינה מלאכותית יכולה להשתמש בסרטון זה כדי ללמוד את הדפוסים שלו, החל בתנועות הידיים שלו ועד להפסקותיו בדיבור. זה יכול אז צפו בזיוף עמוק ממנו ושימו לב איפה זה לא תואם את הדפוסים האלה. לגישה זו יש יתרון בכך שהיא עשויה לעבוד גם אם איכות הווידיאו עצמה מושלמת במהותה.

{vembed Y = gsv1OsCEad0}

ארון לוסון של SRI International מתאר גישה אחת לזיהוי זיוף עמוק.

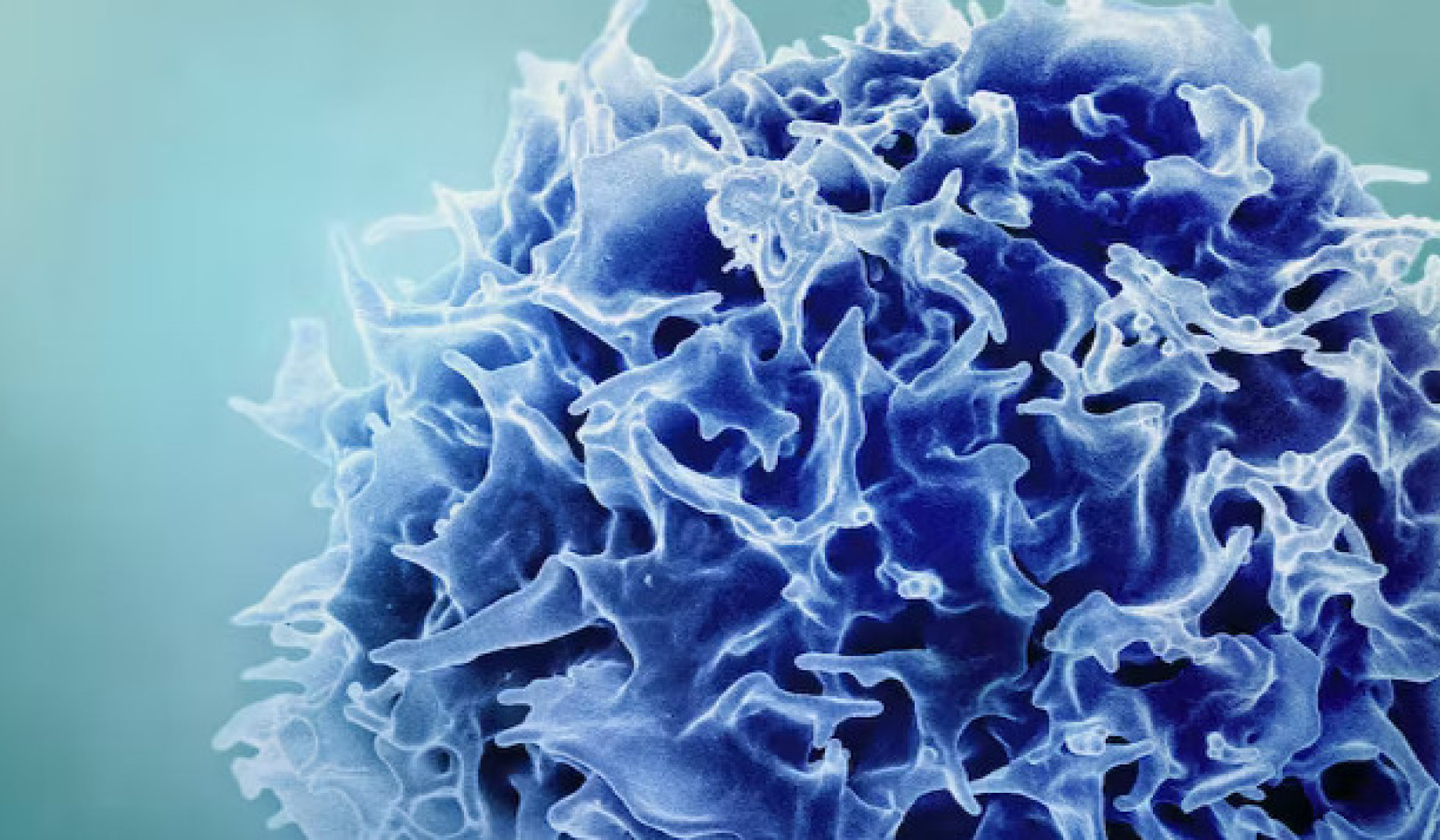

חוקרים אחרים, כולל הצוות שלנו, התמקדו בהם ההבדלים זֶה לכל הזיופים העמוקים לעומת סרטונים אמיתיים. סרטוני Deepfake נוצרים לעיתים קרובות על ידי מיזוג מסגרות שנוצרו באופן אינדיבידואלי ליצירת סרטונים. אם ניקח זאת בחשבון, השיטות של הצוות שלנו מחלצות את הנתונים החיוניים מהפרצופים במסגרות בודדות של וידאו ואז עוקבות אחריהם באמצעות קבוצות של מסגרות במקביל. זה מאפשר לנו לזהות סתירות בזרימת המידע ממסגרת אחת לאחרת. אנו משתמשים בגישה דומה גם למערכת זיהוי השמע המזויפת שלנו.

הפרטים העדינים האלה קשה לאנשים לראות, אך מראים עד כמה זיופים עמוקים אינם לגמרי מושלם עדיין. גלאים כאלה יכולים לעבוד עבור כל אדם, ולא רק על כמה מנהיגים עולמיים. בסופו של דבר, ייתכן שיהיה צורך בשני סוגי גלאי הזיוף העמוק.

מערכות איתור אחרונות מתפקדות טוב מאוד בסרטונים שנאספו במיוחד לצורך הערכת הכלים. למרבה הצער, אפילו הדגמים הטובים ביותר עושים זאת בצורה גרועה בסרטונים שנמצאו ברשת. הצעד הבא הוא שיפור הכלים הללו כך שיהיו חזקים ושימושיים יותר.

מי צריך להשתמש בגלאי זיוף עמוק?

באופן אידיאלי, כלי אימות מזויף עמוק צריך להיות זמין לכולם. עם זאת, טכנולוגיה זו נמצאת בשלבי התפתחות מוקדמים. החוקרים צריכים לשפר את הכלים ולהגן עליהם מפני האקרים לפני שהם משחררים אותם באופן נרחב.

יחד עם זאת, יחד עם זאת, הכלים להכנת זיוף עמוק זמינים לכל מי שרוצה להטעות את הציבור. ישיבה מהצד אינה אפשרות. עבור הצוות שלנו, האיזון הנכון היה לעבוד עם עיתונאים, מכיוון שהם קו ההגנה הראשון מפני התפשטות מידע מוטעה.

לפני פרסום סיפורים, עיתונאים צריכים לאמת את המידע. יש להם כבר שיטות מנוסות, כמו לבדוק עם מקורות ולגרום ליותר מאדם אחד לאמת עובדות מרכזיות. אז על ידי כך שאנחנו מכניסים את הכלי לידיהם, אנחנו נותנים להם מידע נוסף, ואנחנו יודעים שהם לא יסמכו על הטכנולוגיה בלבד, בהתחשב בכך שהיא יכולה לעשות טעויות.

האם הגלאים יכולים לנצח במרוץ החימוש?

זה מעודד לראות קבוצות מ פייסבוק ו מיקרוסופט השקעה בטכנולוגיה כדי להבין ולזהות זיופים עמוקים. תחום זה זקוק למחקר נוסף כדי לעמוד בקצב המהירות של התקדמות הטכנולוגיה המזויפת העמוקה.

עיתונאים ופלטפורמות המדיה החברתית צריכים גם להבין כיצד הכי טוב להזהיר אנשים מפני זיופים עמוקים כאשר הם מתגלים. מחקרים הראו זאת אנשים זוכרים את השקר, אך לא העובדה שזה היה שקר. האם הדבר נכון גם לגבי סרטונים מזויפים? פשוט הכנסת "Deepfake" לכותרת לא מספיקה כדי להתמודד עם סוג של דיסאינפורמציה.

זיוף עמוק כאן כדי להישאר. ניהול דיסאינפורמציה והגנה על הציבור יהיו מאתגרים מתמיד כאשר הבינה המלאכותית תחזק. אנחנו חלק מקהילת מחקר הולכת וגדלה שלוקחת על עצמה את האיום הזה, שבו הגילוי הוא רק הצעד הראשון.![]()

על הכותבים

ג'ון סוהרווארדי, דוקטורנט למדעי המחשוב והמידע, המכון הטכנולוגי של רוצ'סטר ומתיו רייט, פרופסור לאבטחת מחשוב, המכון הטכנולוגי של רוצ'סטר

מאמר זה פורסם מחדש מתוך שיחה תחת רישיון Creative Commons. קרא את ה מְקוֹרִי מאמר.